Dokument Evropske komisije ima za cilj da usmerava osoblje u upravljanju rizicima i ograničenjima generativne veštačke inteligencije kao što su ChatGPT, Bard i Stable Diffusion koji generišu sadržaj na osnovu korisničkih upita.

Evropska komisija je u utorak (30. maja) objavila interne smernice za osoblje o korišćenju i interakciji sa generativnim modelima veštačke inteligencije, posebno o njihovim ograničenjima i rizicima.

Dokument „Smernice za osoblje o korišćenju onlajn dostupnih generativnih modela veštačke inteligencije" i njegova prateća beleška, u koje je uvid imao EURACTIV, stavljeni su na raspolaganje u internom informacionom sistemu Komisije.

Upravni odbor Komisije za upravljanje informacijama usvojio je smernice 27. aprila.

„Smernice pokrivaju alate treće strane javno dostupne na mreži, kao što je ChatGPT. Oni imaju za cilj da pomognu osoblju Evropske komisije u razumevanju rizika i ograničenja koje alati dostupni na mreži mogu doneti i da podrže odgovarajuću upotrebu ovih alata", navodi se u pratećoj belešci.

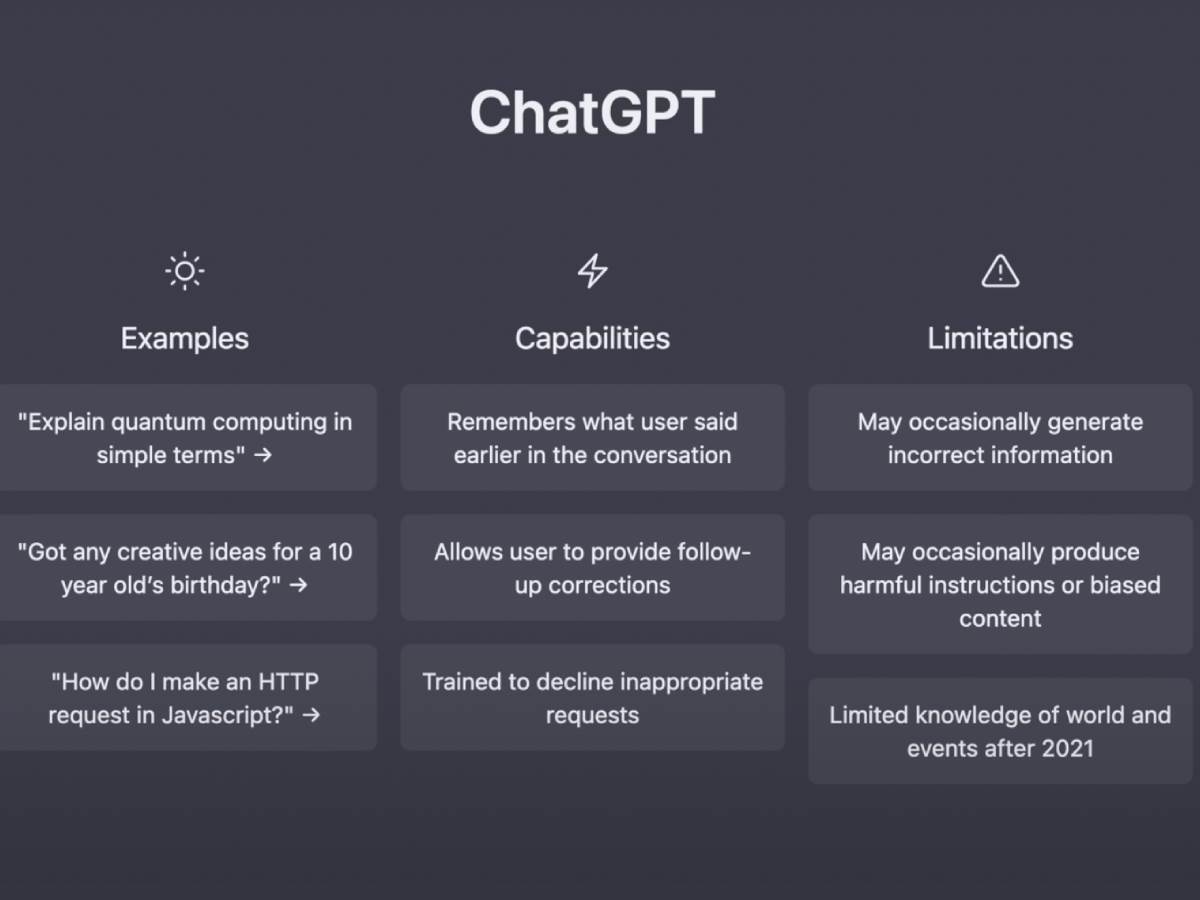

Konkretno, ovaj dokument ima za cilj da usmerava osoblje u upravljanju rizicima i ograničenjima generativne veštačke inteligencije kao što su ChatGPT, Bard i Stable Diffusion koji generišu sadržaj na osnovu korisničkih upita.

Komisija je primetila kako ovi alati imaju potencijal da povećaju efikasnost i poboljšaju kvalitet produktivnosti jer bi mogli da pomognu u pisanju brifinga i razvoju kompjuterskog koda, ali i da se upotreba mora zaštititi pod određenim uslovima.

Smernice napominju da „razmotreni rizici i ograničenja nisu nužno relevantni za interno razvijene generativne AI alate Komisije. Interni alati koje je razvila i/ili kontroliše Komisija će se procenjivati od slučaja do slučaja u okviru postojećeg korporativnog upravljanja za IT sisteme."

Pored toga, naglašava se da ga treba smatrati „živim dokumentom" koji treba da se ažurira na osnovu tehnološkog razvoja i nadolazećih regulatornih intervencija, odnosno Zakona EU o veštačkoj inteligenciji.

Prvi navedeni rizik je obelodanjivanje osetljivih informacija ili ličnih podataka javnosti, jer smernice ističu da se svaki ulaz koji se daje onlajn generativnom modelu veštačke inteligencije zatim prenosi dobavljaču veštačke inteligencije, što znači da se kasnije može uneti u buduće generisane rezultate.

Stoga je osoblju EU zabranjeno da deli „sve informacije koje već nisu u javnom domenu, niti lične podatke, sa onlajn dostupnim generativnim modelom veštačke inteligencije".

Druga tačka se odnosi na potencijalne nedostatke AI modela, koji mogu dovesti do pogrešnih ili pristrasnih odgovora zbog nepotpunog skupa podataka ili dizajna algoritma.

Pravilo je, dakle, da zvaničnici EU „treba da uvek kritički procenjuju svaki odgovor koji proizvede onlajn dostupan generativni model veštačke inteligencije zbog potencijalno pristrasne i netačne informacije".

Štaviše, u dokumentu se dodaje da ovaj nedostatak transparentnosti takođe podrazumeva rizik od kršenja prava intelektualne svojine, posebno autorskih prava, jer bi zaštićeni sadržaj mogao da se koristi za obuku AI modela. Pošto proizvedeni rezultati ne priznaju korišćeni materijal, korisnicima je skoro nemoguće da dobiju neophodno ovlašćenje od nosilaca prava.

Kao rezultat toga, od osoblja se uvek traži da kritički procene da li rezultat generisanog AI krši prava intelektualne svojine, a posebno autorska prava, i da „nikada direktno ne repliciraju rezultate generativnog AI modela u javnim dokumentima, kao što je stvaranje zvaničnih tekstova Komisije, posebno pravno obavezujućih."

Konačno, u dokumentu je naglašeno da generativni AI modeli mogu imati dugo vreme odziva ili da neće biti dostupni sve vreme. Stoga je osoblju Komisije zabranjeno da se oslanja na ove alate za kritične i vremenski osetljive zadatke.

(EURACTIV.rs)